Googleが2月に公開したオープンかつ商用利用可能な大規模言語モデル「Gemma」ファミリーに、新たなモデルとして「CodeGemma」と「RecurrentGemma」の2つを追加すると発表しました。

Gemma Family Expands with Models Tailored for Developers and Researchers – Google for Developers

Gemmaは同じくGoogleが作成しているAIモデル「Gemini」と同じ技術を使用して作成された軽量かつオープンなAIモデルです。2月にベースとなる「事前学習済みモデル」および対話性能を高めた「インストラクションチューニング済みモデル」がリリースされていました。

今回発表されたのは、CodeGemma」と「RecurrentGemma」の2つです。CodeGemmaはコード補完や生成タスク、命令フォローを強化し、RecurrentGemmaは効率を最適化しています。

「CodeGemma」モデルには、20億パラメーターのバリアントが1つと、70億パラメーターのバリアントが2つ存在しています。20億パラメーターのバリアントはローカルコンピューターで高速にコードを補完する用途に適しており、70億パラメーターのバリアントはコード補完とコード生成タスクに特化したものと、コード関連のチャットと命令追従に特化したものが存在しています。

CodeGemmaを他のモデルと比較した結果は、下図の通りです。単一行および複数行のコード補完タスクのパフォーマンスを競合モデルと比較しています。

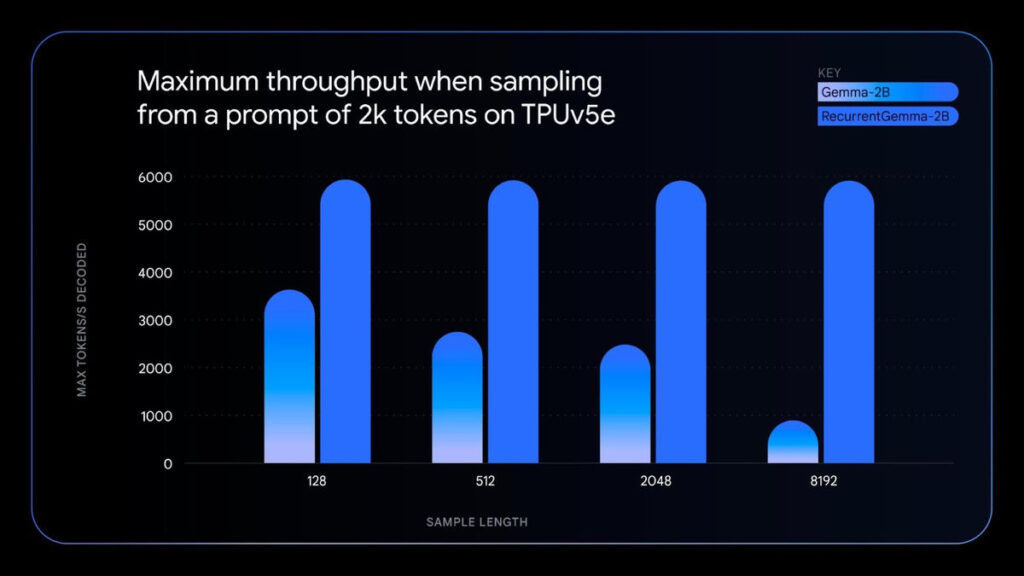

「RecurrentGemma」は、リカレントニューラルネットワークとローカルアテンションを活用してメモリ効率を向上させたモデルです。このモデルは、Gemma 2Bモデルと同様のベンチマークスコアを達成しながら、メモリ使用量を削減し、スループットを大幅に向上させることに成功しました。

左側のGemma 2Bモデルと比較すると、右側のRecurrentGemma 2Bモデルはシーケンスが長くなってもスループットを維持できることが分かります。

「CodeGemma」と「RecurrentGemma」は、通常のGemmaと同様にオープンモデルとして公開されており、商用利用も可能です。また、Googleはこれら2つのモデルのリリースと同時に、元の。Gemmaモデルのバージョン1.1を新たに公開しています。